Приветствую Вас на своем блоге! Тема этой статьи — файл robots.txt для WordPress. Прочитав эту статью, вы узнаете для чего этот файл нужен и как его правильно создать для своего блога на движке WordPress.

Для чего нужен файл robots.txt.

Раньше, когда все страницы сайта были статичными и представляли собой набор HTML страниц, поисковым роботам не представляло труда просканировать их. Такие сайты были не большими, имели всего несколько страниц, связанных между собой ссылками.

Но со временем сайты стали создавать с помощью CMS, другими словами, все сайты стали иметь свой движок. Что позволило создавать более объемные сайты практически любому пользователю, даже не имеющему опыта web программирования.

Но эти перемены привели к тому, что поисковые роботы уже не могли так же легко проверять все страницы сайта, чтобы поисковики их проиндексировали. К тому же для работы сайта на CMS требуется база данных, что так же осложняет задачу поисковым роботам, так как для ее работы требуется много файлов, которые не содержат никакого полезного контента и не нуждаются в индексации.

Еще на современном сайте возможно несколько страниц с одинаковым контентом, например главная страница, страница с полным описанием новости, страница архива записей, страница последних записей.

Поисковому роботу в такой ситуации трудно разобраться, какие страницы нужно индексировать, а какие нет. В этой ситуации могут попасть в индекс совершенно не нужные страницы, а те, которые должны туда попасть, останутся не проиндексированными.

Еще минус такой ситуации состоит в том, что поисковики могут принять много одинаковых страниц, как копирование контента и вы попадете под фильтр поисковых систем, что крайне не желательно. Чтобы этого не произошло, нужно помочь поисковому роботу проиндексировать только нужные вам страницы, и сделать это можно с помощью файла robots.txt.

Это текстовый файл, который лежит в корне сайта и указывает поисковому роботу, какие страницы индексировать, так как при заходе на сайт, он сначала читает этот файл. В нем должно быть прописано, какие страницы добавлять в индекс поисковика, а какие нет.

Обязательно нужно запретить индексирование одинакового контента, также нужно запретить индексацию страниц с плагинами и темами вашего блога, и другие страницы со служебными и временными файлами. Впрочем можно запретить индексацию и всего сайта, например, если он нужен вам только для личных нужд и вы не заинтересованы в том, чтобы его страницы попали в выдачу поисковика.

Даже если у вас в сборке WordPress уже есть файл robots.txt, его обязательно нужно проверить и настроить правильно с учетом ваших пожеланий. Так как невозможно сделать его полностью универсальным для всех сайтов. Если у вас вообще не будет файла robots.txt на сайте, то поисковые роботы будут индексировать все страницы, которые есть на сайте.

Как создать файл robots.txt.

Создать файл robots.txt можно в любом текстовом редакторе, но рекомендую редактор Notepad++ или ему подобный. Вообще, если вы будете редактировать файлы своего блога с помощью редакторов, то лучше пользоваться именно такими, так как они правильно распознают синтаксис и кодировку файлов.

И так создайте текстовый файл и назовите его robots.txt, имейте ввиду, что название файла должно состоять из строчных букв. Далее нужно будет заполнить этот файл правилами для поисковых роботов. Ниже я опишу основные команды и правила файла robots.txt.

Команды для файла robots.txt

User-Agent — это команда файла robots.txt, которая указывает поисковому роботу для какого поисковика действую правила, которые идут ниже этой команды.

Если нужно прописать правила для всех поисковиков, то такую команду нужно написать так:

User-Agent:*

Если вам нужно прописать правила для какого то одного поисковика, то нужно указать его в этой команде, например для Яндекса это будет выглядеть так:

User-Agent: Yandex

Для разных поисковиков используются разные названия, вот несколько из них:

Яндекс — Yandex

Google — GoogleBot

Mail.ru — Mail.ru

Yahoo — Slurp

Bing — bingbot

Но как правило, на блоге WordPress указывают отдельно правила только для поисковика Яндекс, и общие правила для всех остальных поисковиков.

Disallow — команда запрета индексации контента. С ее помощью можно запретить доступ как к каталогам блога, так и к отдельным файлам.

Делается это так:

User-Agent: Yandex

Disallow:/plugin/

Этой командой мы запретим индексацию каталога plugin для поисковика Яндекс.

Нельзя запреты перечислять в одной строке, для каждого файла или каталога, запрет нужно указывать с новой строки. Так запрет Disallow нужно указывать каждый раз с новой строки.

Пустых строк между оператором Disallow быть не должно, так как пустая строка обозначает переход к следующему набору правил.

При указании основного домена сайта в директиве Host, нельзя указывать в этой директории IP адресс, ставить слэш (/) и http:// в начале адреса.

Allow — команда разрешения индексации контента.

Если вам нужно, чтобы поисковый робот добавил в индексацию какую то определенную страницу, то нужно использовать оператор Allow.

Например так:

User-Agent: Yandex

Disallow:/plugin/

Allow:/plugin/Lightbox Gallery

В данном примере команда Disallow запрещает индексацию каталога plugin, а команда Allow разрешает индексацию подкаталога Lightbox Gallery, который находится в каталоге plugin. Так же можно указать любые каталоги и файлы, которые вам нужно обязательно проиндексировать.

Host — директива для указания файлу robots.txt главного адреса сайта. Если у вашего ресурса есть зеркало, то через директиву Host нужно будет указать основной адрес сайта.

Например адреса uznaytut48.ru и www.uznaytut48.ru для поискового робота совершенно разные, и вам нужно будет указать, какой из них является основным. Выглядеть это будет так:

Host: uznaytut48.ru

Я описал основные команды и операторы файла robots.txt. Зная их, вы легко создадите и сможете отредактировать свой файл robots.txt. Приведу пример стандартного файла, который установлен на большинстве блогов и нормально работает.

—————————————

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /category/*

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /*?

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /category/*

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /*?*

Disallow: /tag

Host: ваш сайт

Sitemap: http://ваш сайт/sitemap.xml.gz

Sitemap: http://ваш сайт/sitemap.xml

—————————————-

Слова «ваш сайт» замените на свой домен.

Только учтите, что если у вас не настроен ЧПУ на блоге, то строчку «Disallow: /*?*» нужно будет удалить из этого файла, иначе у вас контент сайта не будет индексироваться.

И обязательно добавьте путь до карты сайта вашего блога.

Disallow: /category/*/*

Дело в том, что такой запрет запрещает только индексацию категорий третьего уровня, а второго разрешает. И получается, что вы запрещаете индексацию только части своих рубрик, а то и вовсе ее разрешаете, но сами того не зная.

В итоге, ваши блоги развиваются и индексируются нормально, не смотря на эту ошибку. Что только подтверждает, что запрет на индексацию категорий не обязателен.

Но если вы все таки решили запретить рубрики, то правильно будет написать так:

Disallow: /category/*

или

Disallow: /category

Так точно все категории будут закрыты от индексации.

Кстати, индексацию рубрик чаще всего закрывают с помощью плагина All In One SEO Pack, так что в robots.txt отпадает необходимость их закрывать.

Как проверить файл robots.txt.

Проверить, правильно ли индексируются ваши страницы на блоге, можно с помощью инструмента Яндекс-Вебмастер. Если по результатам его проверки у вас все будет нормально, то и другие роботы проиндексируют ваш сайт нормально.

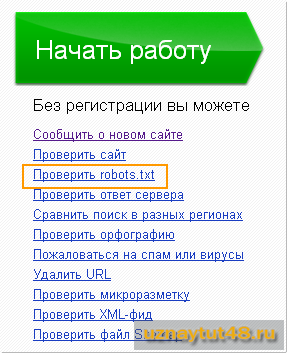

Чтобы проверить файл robots.txt с помощью панели Яндекс-Вебмастер, даже не нужно регистрироваться там.

Заходите на главную страницу этого инструмента и в разделе «Начать работу» нажимаете ссылку «Проверить robots.txt».

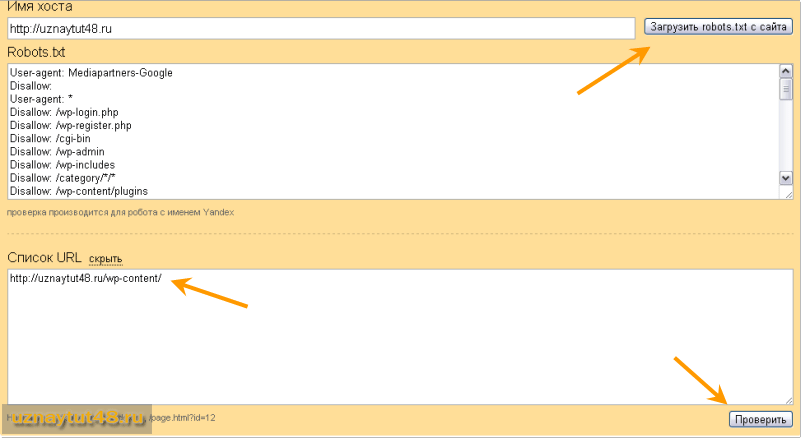

Далее вводите в поле «Имя хоста» адрес своего сайта и нажимаете кнопку «Загрузить robots.txt с сайта».

В поле «Список URL» нажимаете «Добавить», и пишите путь до той страницы своего сайта, которую хотите проверить.

Затем нажимаете кнопку «Проверить».

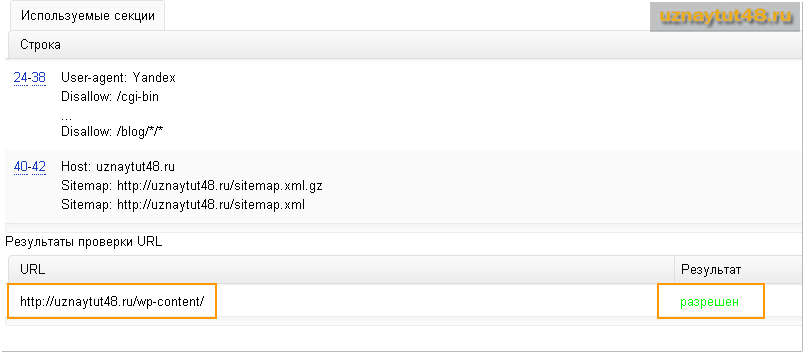

После проверки вы увидите результат, разрешена ли индексация страницы или нет. В поле «Добавить URL» вы можете добавить любую страницу своего сайта, а не только такую, как на примере.

На этом пожалуй все, надеюсь эта статья вам поможет разобраться с файлом robots.txt и вы его быстро настроите на своем сайте.

Если у вас еще не стоит плагин Login LockDown на блоге, то рекомендую его поставить, этот плагин поможет надежно защитить ваш блог от взлома.

Удачи!

С уважением Юрий Хрипачев.

Вот только что тоже проверил, написало что разрешено. Но вот я не помню что бы вписывал команды, а в Robots.txt написано только это!

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Sitemap: http://dyshlyuk.com/sitemap.xml

В чём отличие файлов robots.txt и .haccess?

Файл robots.txt нужен для поисковых роботов и индексации сайта, а .haccess для конфигурации сервера Apache.

Юрий, с наступившим Новым 2014 Годом вас! Пусть этот год принесет вам радости, везения и счастья!

А теперь по поводу статьи. Хорошую тему вы затронули, т.к. я много встречаю про этот файл, но с установкой еще не занималась. А чем отличается адрес с www от без него? Недавно стала замечать такую разницу при написании, а не понимаю что их отличает. Спасибо.

Спасибо за поздравления. И Вас С Новым Годом!

По большому счету, разница в том и состоит, что www или есть в домене, или его нет. Будете создавать сайт, обратите внимание на домен и всегда, во всех сервисах, указывайте правильный вариант.

А так, это тема отдельного поста и в комментариях ее не раскрыть полностью.

От правильного составления этого файла зависит много! Отличная статья!

Добрый день! Подскажите, а проверить на сайте Яндекс можно всем сайтам или только те, которые уже существуют давно и проиндексированы поисковиками.

Дело в том, что у меня только что созданный сайт, я могу проверить таким способом через Яндекс-Вебмастер свой сайт?

Здравствуйте!.

Я только что созданный сайт не проверял, но посмотрел ваш, который указан в комментариях, так у вас вообще нет robots.txt на сайте.

Юрий а как проверить посторонний сайт, на наличие robots.txt?

Легко Антон, введите после домена любого сайта /robots.txt и он как на ладони у вас.

Проверил свои (плачевно), у меня прописано по самому минимуму.

Вот все что там есть

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Путь к карте сайта.

Это плохо или нормально?

Я бы сказал, что это плохо, значит у вас лишние файлы индексируются, и архивы и страницы и разный мусор. Посмотрите сами, какие страницы у вас в индексе, а то так и под фильтр можно улететь.

Что бы переделать нужно только открыть робот.тхт и вставить туда все команды, которые вы писали в статье?

Да, просто откройте его для редактирования и измените.

Спасибо! Кстати команда /robots.txt на все движки действует или только на вордпрес?

Если честно, то без понятия, я не проверял robots.txt на всех сайтах.

Работает, но на всех не получилось проверить!

Если хотите себе правильно настроить robots.txt, то лучше просто посмотрите, как он настроен на раскрученных сайтах, с посещаемостью 5000-7000 человек и смело делайте также.

Только все равно нужно понимать какой запрет или разрешение для чего установлено. И видеть те закрытые каталоги, которые автор сам создал и закрыл от индексации. Если их у вас нет, то и закрывать их не нужно.

Есть один блог конкурент, нужно будет на нем посмотреть) На том блоге нет ссылок ведущих на сайт и посещаемость 9 000 в сутки, как у него получается, я не знаю)

Кстати Юрий, хотел у вас спросить, вы как бы правильно настроили робот.тхт, а в чем тогда причина что в гугле у вас 2700 проиндексированных страниц, хоть статей не больше 200. В Яндексе 480)

Затрудняюсь точно ответить почему, но такая разница идет давно. Скорее всего у них разные параметры для индексирования страниц. В Яндексе загружено больше 2500 страниц, но в поиске пока только 405.

Я где то слышал, что Яндекс более жестко относится к дублирующим страницам, а вот гугл проще, по этой причине и большое количество разрыва, в индексируемых страницах.

После этого, тема на вашем сайте будет отображаться на русском языке. Но не останавливайтесь на этом! Если вы перевели тему для WordPress на русский язык, вы можете связаться с автором этой темы и отправить ему ваши файлы перевода .po и .mo. Автор может включить новый перевод при выпуске следующего обновления к своей теме, и другие пользователи WordPress смогут наслаждаться темой на русском языке.